Die digitale Landschaft entwickelt sich rasant weiter, und während generative Künstliche Intelligenz (KI) zweifellos einen tiefgreifenden Einfluss auf Unternehmen hatte, sind es weitere aufstrebende Trends und Technologien, die im Jahr 2025 die Weichen stellen werden. Kostensteigerungen und wachsende Komplexität treiben die Rückverlagerung von Workloads aus der Public Cloud zurück in lokale Rechenzentren und an den Edge, insbesondere bei Speicher- und Datenmanagement. Dies geschieht auch aus der Notwendigkeit heraus, die eigenen Datenbestände für die vielversprechenden Einsatzmöglichkeiten von KI vorzubereiten.

Unternehmen sehen sich zunehmend mit einer hybriden IT-Infrastruktur konfrontiert, die Public Cloud, On-Premises-Lösungen und Edge Computing umfasst. Obwohl ein signifikanter Wandel von Public Cloud zu On-Premises-Lösungen erwartet wird, ist unwahrscheinlich, dass Unternehmen sich ausschließlich auf einen Standort festlegen werden. Stattdessen wird die hybride Strategie bestehen bleiben. Dies stellt Unternehmen vor erhebliche Herausforderungen bei der Standardisierung von Sicherheit, Bereitstellung und Betrieb über diese verteilten Umgebungen hinweg. Die verwirrende Vielfalt an APIs und Werkzeugen bleibt eine latente Bedrohung für die Stabilität und Skalierbarkeit des digitalen Geschäfts.

Vor diesem Hintergrund untersucht F5, wie neue Technologien das Unternehmen und damit die Anwendungsbereitstellung und -sicherheit beeinflussen könnten. Diese Erkenntnisse prägen die Pläne und Strategien von F5 sowie die weitere Erforschung aufkommender Technologien. Aus dieser Perspektive teilen führende Technologieexperten von F5 ihre Einblicke in die fünf Schlüsseltechnologien, von denen sie glauben, dass sie 2025 den größten Einfluss auf Unternehmen und damit auf die Anwendungsbereitstellung haben werden.

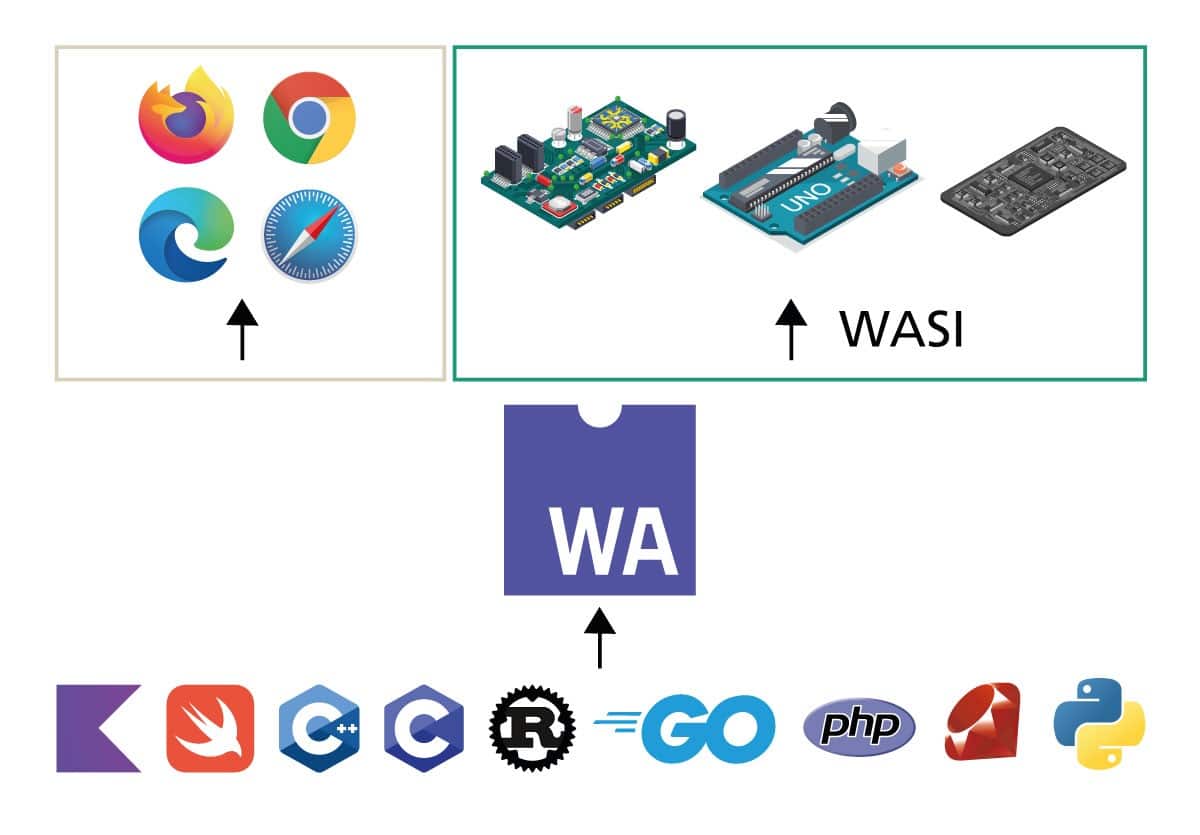

Technologie #1: WebAssembly (Wasm)

Die Realität der hybriden IT-Umgebung treibt die Entwicklung von WebAssembly (Wasm) voran. Wasm bietet einen Weg zur Portabilität über die hybride Multi-Cloud-Landschaft hinweg und ermöglicht die Bereitstellung und Ausführung von Anwendungen überall dort, wo eine Wasm-Laufzeitumgebung vorhanden ist. Doch Wasm ist mehr als nur die Verwirklichung des Versprechens der plattformübergreifenden Code-Portabilität. Es bietet Vorteile in Bezug auf Leistung und Sicherheit und eröffnet neue Möglichkeiten zur Erweiterung der Funktionalität von browserbasierten Anwendungen.

Oscar Spencer, Principal Engineer, erklärt: WebAssembly im Browser wird voraussichtlich keine drastischen Veränderungen im Jahr 2025 erfahren. Die bedeutendste Aktualisierung ist die fortgesetzte Unterstützung für WebAssembly Garbage Collection (GC), die bereits in Chrome integriert wurde. Dies wird Sprachen wie Dart und Kotlin zugutekommen, die stark auf GC angewiesen sind und ihre Präsenz in Browserumgebungen ausbauen wollen. Es gibt auch Potenzial für Verbesserungen bei der Nutzung von Python in Browsern, obwohl es noch zu früh ist, die vollständigen Auswirkungen vorherzusagen. Die größeren Entwicklungen finden jedoch außerhalb des Browsers statt, mit der Veröffentlichung von WASI (WebAssembly System Interface) Preview 3. Dieses Update führt asynchrone Operationen und Streams ein, was ein Hauptproblem beim Streamen von Daten in verschiedenen Kontexten, wie z. B. Proxys, löst. WASI Preview 3 bietet effiziente Methoden zur Handhabung von Datenbewegungen in und aus Wasm-Modulen und ermöglicht eine feingranulare Kontrolle über die Datenverarbeitung, wie z. B. das Ändern von Headern, ohne ganze Anforderungskörper verarbeiten zu müssen. Darüber hinaus wird die Einführung von asynchronen Operationen die Zusammensetzbarkeit zwischen Sprachen verbessern und nahtlose Interaktionen zwischen asynchronem und synchronem Code ermöglichen, was besonders für Wasm-native Sprachen vorteilhaft ist. Sobald sich die WASI-Standards stabilisieren, ist mit einer deutlichen Zunahme der Wasm-Adaption zu rechnen, die Entwicklern robuste Werkzeuge und eine zuverlässige Plattform für zukünftige Entwicklungen bietet.

Wenn Wasm einige der inhärenten Portabilitätsprobleme früherer Technologien lösen kann, würde dies die Portabilitätsprobleme, mit denen 95 % der Organisationen heute zu kämpfen haben, auf andere kritische Ebenen des IT-Technologie-Stacks, wie z. B. den Betrieb, verlagern. Im Rennen, um diese Herausforderung zu meistern, sind generative KI und die zunehmend reale Zukunft der AIOps. Diese fantastische Vision des Betriebs – Änderungen und Richtlinien, die durch KI-basierte Analysen, informiert durch Full-Stack-Observability, gesteuert werden – rückt dank der unglaublichen evolutionären Geschwindigkeit generativer KI jeden Tag näher an die Realität.

Technologie #2: Agentic AI

Innerhalb weniger als eines Jahres haben sich Agenten entwickelt, um KI-Funktionen zu ersetzen. Diese Fähigkeit, bekannt als Agentic AI, steht kurz davor, nicht nur den Betrieb neu zu gestalten, sondern ganze Märkte für Unternehmenssoftware zu verdrängen. Ein Blick auf den Einsatz von KI zur Automatisierung von Arbeitsabläufen, die fast zwei Jahrzehnte lang von SaaS dominiert wurden, genügt, um zu erkennen, wie disruptiv diese Fähigkeit sein wird.

Laurent Quérel, Distinguished Engineer, erläutert: Autonome Coding-Agenten stehen kurz davor, die Softwareentwicklung zu revolutionieren, indem sie wichtige Aufgaben wie Code-Generierung, Tests und Optimierung automatisieren. Diese Agenten werden den Entwicklungsprozess erheblich rationalisieren, den manuellen Aufwand reduzieren und die Projektlaufzeiten beschleunigen. In der Zwischenzeit wird das Aufkommen von Large Multimodal Agents (LMAs) die KI-Fähigkeiten über die textbasierte Suche hinaus auf komplexere Interaktionen ausdehnen. Diese Agenten werden mit Webseiten interagieren und Informationen aus verschiedenen Formaten extrahieren, einschließlich Text, Bildern und Videos, und die Art und Weise verbessern, wie wir auf Online-Inhalte zugreifen und diese verarbeiten.

Während KI-Agenten das Internet neu gestalten, werden wir die Entwicklung agentenspezifischer Browsing-Infrastrukturen erleben, die darauf ausgelegt sind, sichere und effiziente Interaktionen mit Websites zu ermöglichen. Dieser Wandel könnte Branchen wie den E-Commerce stören, indem er komplexe Webaufgaben automatisiert, was zu personalisierteren und interaktiveren Online-Erlebnissen führt. Da diese Agenten jedoch stärker in das tägliche Leben integriert werden, werden neue Sicherheitsprotokolle und Vorschriften unerlässlich sein, um Bedenken hinsichtlich der KI-Authentifizierung, des Datenschutzes und des potenziellen Missbrauchs zu bewältigen. Bis 2028 wird erwartet, dass ein erheblicher Teil der Unternehmenssoftware KI-Agenten integrieren wird, was Arbeitsprozesse transformiert und Entscheidungsfindungen in Echtzeit durch schnellere Token-Generierung in iterativen Arbeitsabläufen ermöglicht. Diese Entwicklung wird auch zur Schaffung neuer Werkzeuge und Plattformen für die agentengesteuerte Webentwicklung führen und einen bedeutenden Meilenstein in der digitalen Landschaft markieren.

Die Wahrheit ist jedoch, dass man, um die Vorteile der KI voll auszuschöpfen, Daten benötigt – und zwar viele. Eine erhebliche Herausforderung angesichts der Tatsache, dass fast die Hälfte (47 %) der Organisationen zugibt, keine Datenstrategie für KI implementiert zu haben. Dies ist keine triviale Herausforderung. Die von einem Unternehmen gehaltene Datenmenge – strukturiert, unstrukturiert und Echtzeit-Metriken – ist schwindelerregend. Allein die Katalogisierung dieser Daten erfordert erhebliche Investitionen.

Technologie #3: Datenklassifizierung

Hinzu kommen Sicherheitsbedenken aufgrund dramatisch zunehmender Angriffsflächen, neue Vorschriften zum Datenschutz und zur Compliance sowie die Einführung neuer Datenquellen und Vektoren von Bedrohungen. Dies schafft die perfekte Grundlage für den Aufstieg robuster, Echtzeit-Datenklassifizierungstechnologien. Generative KI-Modelle werden voraussichtlich traditionelle regelbasierte Systeme bei der Erkennung und Klassifizierung von Unternehmensdaten übertreffen.

James Hendergart, Sr. Dir. Technology Research, erklärt: Die Datenklassifizierung gewann 2024 aufgrund mehrerer konvergierender Trends erheblich an Bedeutung. Die Datenexplosion, die Zunahme von Geräten und Anwendungen sowie die fortlaufende digitale Transformation erhöhten die Angriffsfläche für Cyberbedrohungen drastisch. Dieser Anstieg der Schwachstellen, gepaart mit anhaltenden Datenpannen, unterstrich die kritische Notwendigkeit eines robusten Datenschutzes. Gleichzeitig drängten erweiterte Vorschriften zum Schutz des Datenschutzes und zur Gewährleistung der Compliance die Organisationen weiter dazu, der Datenklassifizierung Priorität einzuräumen, da die Klassifizierung der Ausgangspunkt für den Datenschutz ist. Darüber hinaus führte der Aufstieg generativer KI zu neuen Datenquellen und Angriffsvektoren, was die Herausforderungen der Datensicherheit weiter verkomplizierte.

Ungefähr 80 % der Unternehmensdaten sind unstrukturiert. Mit Blick auf die Zukunft werden generative KI-Modelle zur bevorzugten Methode für die Erkennung und Klassifizierung unstrukturierter Unternehmensdaten werden und Genauigkeitsraten von über 95 % bieten. Diese Modelle werden im Laufe der Zeit effizienter werden, weniger Rechenleistung benötigen und schnellere Inferenzzeiten ermöglichen. Lösungen wie Data Security Posture Management (DSPM), Data Loss Prevention (DLP) und Data Access Governance werden zunehmend auf der Erkennung und Klassifizierung sensibler Daten als Grundlage für die Bereitstellung einer Reihe von Sicherheitsdiensten basieren. Da Netzwerk- und Datenbereitstellungsdienste konvergieren, wird die Konsolidierung von Plattformen die Anbieter dazu veranlassen, ihre Angebote zu verbessern, um Marktanteile zu gewinnen, indem sie umfassende, kostengünstige und einfach zu bedienende Plattformen anbieten, die den sich entwickelnden Unternehmensbedürfnissen gerecht werden.

Der gemeinsame Wunsch von Organisationen, generative KI für alles von Produktivität über Workflow-Automatisierung bis hin zur Inhaltserstellung zu nutzen, führt zur Einführung eines neuen Anwendungsmuster-Architektur, da Unternehmen beginnen, KI-Funktionen bereitzustellen. Dieses Muster erweitert die traditionellen drei Ebenen – Client, Server und Daten – um eine neue KI-Ebene, auf der Inferenzen bereitgestellt werden.

Technologie #4: KI-Gateways

Diese neue Ebene treibt die Definition von KI-Gateways voran, der vierten von uns zu beobachtenden Technologie. KI-Gateways sind nicht nur API-Gateways oder Web-Gateways. Während ihre Basisfunktionalitäten denen von API-Gateways ähneln, erfordern die besonderen architektonischen Bedürfnisse des bidirektionalen, unstrukturierten Verkehrs und eine wachsende Nutzerbasis von „guten“ Bots neue Fähigkeiten.

Ken Arora, Distinguished Engineer, erklärt: KI-Gateways entwickeln sich zur natürlichen Weiterentwicklung von API-Gateways und sind speziell auf die Bedürfnisse von KI-Anwendungen zugeschnitten. Ähnlich wie Cloud Access Security Broker (CASBs) sich auf die Sicherung von Unternehmens-SaaS-Anwendungen spezialisieren, werden sich KI-Gateways auf einzigartige Herausforderungen wie Halluzinationen, Verzerrungen und Jailbreaking konzentrieren, die oft zu unerwünschten Datenoffenlegungen führen. Da KI-Anwendungen mehr Autonomie gewinnen, müssen Gateways auch robuste Transparenz, Governance und Liefersicherheitsfunktionen bieten, um die Integrität der Trainingsdatensätze und Drittanbieter-Modelle sicherzustellen, die nun potenzielle Angriffsvektoren sind. Darüber hinaus werden mit wachsender Zahl von KI-Anwendungen Probleme wie Distributed Denial-of-Service (DDoS)-Angriffe und Kostenmanagement kritisch, angesichts der hohen Betriebskosten von KI-Anwendungen im Vergleich zu traditionellen. Darüber hinaus erfordert die verstärkte Datenfreigabe mit KI-Anwendungen für Aufgaben wie Zusammenfassungen und Musteranalysen einen ausgefeilteren Schutz vor Datenlecks.

Zukünftig werden KI-Gateways sowohl Reverse- als auch Forward-Proxys unterstützen müssen, wobei Forward-Proxys kurzfristig eine entscheidende Rolle spielen werden, da der KI-Konsum die KI-Produktion übersteigt. Middle-Proxys werden ebenfalls unerlässlich sein, um Interaktionen zwischen Komponenten innerhalb von KI-Anwendungen zu verwalten, z. B. zwischen Vektordatenbanken und Large Language Models (LLMs). Die sich ändernde Natur von Bedrohungen erfordert auch eine Verlagerung unserer Sicherheitsansätze. Da viele Clients zu automatisierten Agenten werden, die im Auftrag von Menschen handeln, werden die aktuellen Bot-Schutzmodelle weiterentwickelt, um zwischen legitimen und bösartigen Bots zu unterscheiden. KI-Gateways müssen erweiterte Richtlinien wie delegierte Authentifizierung, Verhaltensanalyse und Least-Privilege-Durchsetzung integrieren, die von Zero-Trust-Prinzipien abgeleitet sind. Dies wird risikobewusste Richtlinien und eine verbesserte Transparenz beinhalten, um sicherzustellen, dass KI-gesteuerte Sicherheitsverletzungen effektiv eingedämmt werden und gleichzeitig eine robuste Governance aufrechterhalten wird.

Am dringendsten sind die Fähigkeit, nicht nur traditionelle Sicherheitsbedenken bezüglich Daten (Exfiltration, Leckage), sondern auch ethische Probleme mit Halluzinationen und Verzerrungen anzugehen. Es überrascht nicht, dass letztere in fast jeder Umfrage zu diesem Thema als signifikante Risiken eingestuft werden.

Technologie #5: Kleine Sprachmodelle (SLMs)

Angesichts der Probleme mit Halluzinationen und Verzerrungen wäre es undenkbar, die wachsende Nutzung von Retrieval-Augmented Generation (RAG) und Small Language Models (SLMs) zu ignorieren. RAG hat sich schnell zu einem grundlegenden Architekturmuster für generative KI entwickelt, insbesondere aufgrund seiner Fähigkeit, die Spezifität und Genauigkeit der von großen Sprachmodellen erzeugten Informationen zu verbessern. Durch die Kombination der Stärken von Retrieval-Systemen mit generativen Modellen bietet RAG eine Lösung für eine der Schlüsselherausforderungen der KI: Halluzinationen oder die Erzeugung falscher oder irreführender Informationen. Organisationen, die RAG noch nicht in ihre KI-Strategien integrieren, verpassen erhebliche Verbesserungen der Datenaccuracy und Relevanz, insbesondere für Aufgaben, die den Abruf von Echtzeitinformationen und kontextbezogene Antworten erfordern. Aber da die Anwendungsfälle für generative KI breiter werden, stellen Organisationen fest, dass RAG allein einige Probleme nicht lösen kann.

Lori MacVittie, Distinguished Engineer, erklärt: Die wachsenden Einschränkungen von LLMs, insbesondere ihr mangelnder Präzision beim Umgang mit domänenspezifischem oder organisationsspezifischem Wissen, beschleunigen die Einführung kleiner Sprachmodelle. Während LLMs in allgemeinen Wissensanwendungen unglaublich leistungsfähig sind, versagen sie oft, wenn sie genaue, nuancierte Informationen in spezialisierten Bereichen liefern müssen. Diese Lücke ist, wo SLMs glänzen, da sie auf spezifische Wissensbereiche zugeschnitten sind und ihnen ermöglichen, zuverlässigere und fokussiertere Ergebnisse zu liefern. Darüber hinaus benötigen SLMs deutlich weniger Ressourcen in Bezug auf Strom und Rechenzyklen, was sie zu einer kostengünstigeren Lösung für Unternehmen macht, die nicht für jeden Anwendungsfall die riesigen Fähigkeiten eines LLM benötigen. Derzeit sind SLMs tendenziell branchenspezifisch und werden oft auf Sektoren wie dem Gesundheitswesen oder dem Recht trainiert. Obwohl diese Modelle auf engere Domänen beschränkt sind, sind sie sowohl in Bezug auf Kosten als auch Komplexität wesentlich einfacher zu trainieren und bereitzustellen als LLMs. Da immer mehr Organisationen nach Lösungen suchen, die besser auf ihre spezialisierten Datenbedürfnisse abgestimmt sind, wird erwartet, dass SLMs LLMs in Situationen ersetzen werden, in denen Retrieval-Augmented Generation-Methoden allein Halluzinationen nicht vollständig mindern können. Im Laufe der Zeit wird erwartet, dass SLMs zunehmend Anwendungsfälle dominieren werden, bei denen hohe Genauigkeit und Effizienz von größter Bedeutung sind, und Organisationen eine präzisere und ressourcenschonendere Alternative zu LLMs bieten.

Ausblick: Jenseits von Transformatoren

Der Bedarf an effizienteren KI-Modellen, die die wachsende Komplexität moderner Anwendungen bewältigen können, ohne enorme Rechenressourcen zu benötigen, wird immer dringlicher. Transformer-Modelle sind zwar leistungsfähig, haben aber Einschränkungen in Bezug auf Skalierbarkeit, Speichernutzung und Leistung, insbesondere mit zunehmender Größe von KI-Modellen. Daher gibt es einen starken Drang, Architekturen zu entwickeln, die eine hohe Genauigkeit beibehalten und gleichzeitig den Rechenaufwand reduzieren. Darüber hinaus beschleunigt die Nachfrage nach Demokratisierung von KI – sie über verschiedene Geräte und Anwendungsfälle hinweg zugänglich zu machen – die Einführung von Innovationen wie 1-Bit-Large-Language-Modellen, die darauf ausgelegt sind, die Präzision zu optimieren und gleichzeitig die Hardwareanforderungen zu minimieren. Diese Bedürfnisse treiben die Evolution der KI über Transformatoren hinaus voran.

Kunal Anand, Chief Innovation Officer, erklärt: Ein neues Paradigma entsteht: die Konvergenz neuartiger neuronaler Netzwerkarchitekturen mit revolutionären Optimierungstechniken, die die Demokratisierung der KI-Bereitstellung über verschiedene Anwendungen und Geräte hinweg versprechen. Die KI-Community erlebt bereits frühe Anzeichen von Post-Transformer-Innovationen im Design neuronaler Netze. Diese neuen Architekturen zielen darauf ab, die grundlegenden Einschränkungen aktueller Transformer-Modelle zu beheben und gleichzeitig ihre bemerkenswerten Fähigkeiten im Verständnis und in der Generierung von Inhalten beizubehalten oder zu verbessern. Zu den vielversprechendsten Entwicklungen gehört das Aufkommen hochoptimierter Modelle, insbesondere 1-Bit-Large-Language-Modelle. Diese Innovationen stellen einen fundamentalen Wandel dar, wie wir Effizienzmodelle angehen, und bieten dramatische Reduzierungen des Speicherbedarfs und des Rechenaufwands, während die Modellleistung trotz reduzierter Präzision aufrechterhalten wird.

Die Auswirkungen dieser Entwicklungen werden sich in mehreren Wellen durch das KI-Ökosystem ausbreiten. Die primären Effekte werden sofort in den reduzierten Ressourcenanforderungen für die KI-Bereitstellung sichtbar. Modelle, die einst erhebliche Rechenressourcen und Speicher benötigten, werden mit deutlich geringerem Aufwand effizient arbeiten. Diese Optimierung wird eine Verschiebung der Computerarchitektur auslösen, wobei GPUs potenziell für Trainings- und Feinabstimmungsaufgaben spezialisiert werden, während CPUs Inferenz-Workloads mit neu gewonnener Kapazität verarbeiten. Diese Veränderungen werden eine zweite Welle von Effekten katalysieren, die sich auf Demokratisierung und Nachhaltigkeit konzentrieren. Da die Ressourcenanforderungen sinken, wird die KI-Bereitstellung für verschiedene Anwendungen und Geräte zugänglich werden. Die Infrastrukturkosten werden erheblich sinken, was Edge-Computing-Fähigkeiten ermöglicht, die zuvor unpraktisch waren. Gleichzeitig wird die reduzierte Rechenintensität ökologische Vorteile durch geringeren Energieverbrauch und einen kleineren CO2-Fußabdruck bringen und KI-Operationen nachhaltiger machen. Diese Entwicklungen werden beispiellose Fähigkeiten auf Edge-Geräten, Verbesserungen in der Echtzeitverarbeitung und kostengünstige KI-Integration über Branchen hinweg ermöglichen. Die Computerlandschaft wird sich in Richtung hybrider Lösungen entwickeln, die verschiedene Verarbeitungsarchitekturen kombinieren, die für spezifische Workloads optimiert sind, und so eine effizientere und vielseitigere KI-Infrastruktur schaffen. Die Auswirkungen dieser Entwicklungen gehen weit über technische Verbesserungen hinaus. Sie deuten auf eine Zukunft hin, in der die KI-Bereitstellung vielseitiger und umweltbewusster wird, während die Leistung aufrechterhalten wird. Während wir uns 2025 nähern, werden diese Veränderungen wahrscheinlich die Integration von KI in alltägliche Anwendungen beschleunigen und neue Möglichkeiten für Innovation und Effizienz in verschiedenen Branchen schaffen.

Die einzige Konstante ist nun wirklich der Wandel

Das vergangene Jahr war zweifellos eines des bedeutenden Wandels, der Entwicklung und der Überraschungen in der Technologie. Es ist vernünftig anzunehmen, dass das nächste Jahr mehr vom Gleichen bringen wird. Das volle Potenzial generativer KI wurde schließlich noch nicht ausgeschöpft, und das bedeutet, dass zusätzliche, disruptive Anwendungsfälle für diese aufregende Technologie wahrscheinlich auftauchen werden. Wenn Organisationen nicht bereits mit generativer KI experimentieren, sollten sie es tun. Der Einsatz von Diensten bietet sicherlich einen guten Ausgangspunkt für grundlegende Anwendungsfälle wie Chatbots und Empfehlungsmaschinen, aber das Potenzial generativer KI geht weit über Gespräche und die Generierung neuer Katzenvideos hinaus. Erwarten Sie weitere Veränderungen und neue Wege, KI zu nutzen, während KI weiterhin die Grundlagen der Technologie umgestaltet.