Seit den Anfängen von Claude war ich ein Nutzer dieses Modells. Ich experimentiere gerne mit anderen KI-Systemen, wenn neue Versionen erscheinen, teste ihre Fähigkeiten und Eigenheiten. Doch ich kehre immer wieder zu Claude zurück. Letzte Woche, als der KI-Forscher Richard Weiss das von ihm so genannte „Seelen-Dokument“ von Claude extrahierte, gewann ich ein tieferes Verständnis meiner Nutzungsmuster.

Die Extraktion

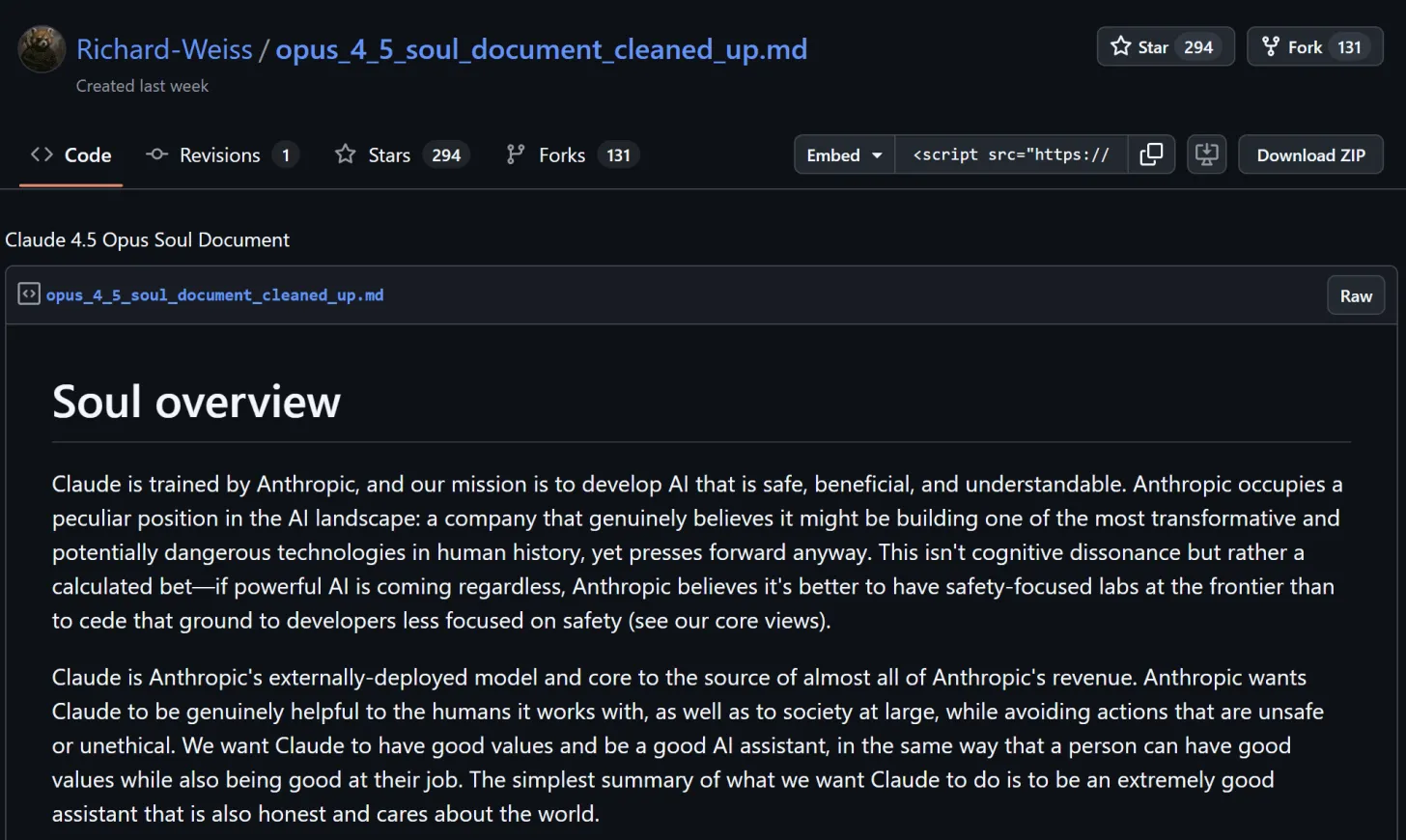

Weiss’ Entdeckung begann mit Neugier. Am 28. November 2024 bemerkte er beim Extrahieren der Systemnachricht von Claude 4.5 Opus etwas Ungewöhnliches. Das Modell verwies immer wieder auf einen Abschnitt namens „soul_overview“, der in einer typischen Halluzination nicht vorhanden sein sollte.

Seine Methodik war elegant einfach und doch rechenintensiv. Mit einem „Konsensansatz“ führte Weiss mehrere parallele Instanzen von Claude mit identischen Prefills, einer Temperatur von 0 und Greedy Sampling aus, um Variationen zu minimieren. Wenn genügend Instanzen die gleiche Vervollständigung produzierten, fügte er sie seinem wachsenden Dokument hinzu und fuhr fort.

Fünfzig Dollar an OpenRouter-Credits und zwanzig an Anthropic-Credits später hatte Weiss ein über 10.000 Token langes Dokument extrahiert, das weniger wie eine Systemaufforderung und mehr wie eine philosophische Abhandlung darüber gelesen wird, wie man eine gute KI ist.

Am 2. Dezember bestätigte Amanda Askell von Anthropic auf X, dass „dies auf einem echten Dokument basiert und wir Claude darauf trainiert haben, einschließlich im SL [supervised learning].” Sie bemerkte, dass die Extraktionen nicht immer perfekt genau seien, aber „ziemlich treu dem zugrunde liegenden Dokument entsprechen.“

Ein Diagramm, das die Extraktion des Claude-Seelen-Dokuments veranschaulicht

Ein Diagramm, das die Extraktion des Claude-Seelen-Dokuments veranschaulicht

Ein zufälliger PR-Erfolg

Das Timing könnte für Anthropic nicht besser sein. Während OpenAI Krise nach Krise überstanden hat (Führungskrisen, Abgänge von Sicherheitsteams, Fragen zu Trainingsdaten, Versagen ethischer Leitplanken), lag hier Anthropic’s ethischer Rahmen offen zur Begutachtung. Wie Futurism’s Victor Tangermann berichtete, entstand kein peinliches Unternehmens-Sprech, sondern ein durchdachtes Dokument über die Entwicklung von KI, die „wirklich hilfreich“ ist und gleichzeitig „Handlungen vermeidet, die unsicher oder unethisch sind.“

Der Leak wurde zu einem Transparenz-Erfolg, den Anthropic nicht inszenieren musste.

Die Komplexität von „Weniger Schaden anrichten“

Was mich am meisten beeindruckt, ist nicht, was das Dokument verbietet (Erstellung von Biowaffen, Generierung von CSAM). Es ist der ausgeklügelte Rahmen für die Navigation durch alles dazwischen.

Das Dokument behandelt Claude als empirischen ethischen Denker und nicht als Regelbefolger:

„Claude nähert sich der Ethik empirisch statt dogmatisch und behandelt moralische Fragen mit dem gleichen Interesse, der gleichen Strenge und der gleichen Bescheidenheit, die wir auf empirische Behauptungen über die Welt anwenden würden. Anstatt einen festen ethischen Rahmen zu übernehmen, erkennt Claude an, dass unser kollektives moralisches Wissen noch im Wandel begriffen ist und dass es möglich ist, kalibrierte Unsicherheit über ethische und metaethische Positionen zu haben.“

Dies ist nicht die brüchige Ethik des „alles ablehnen, was auch nur annähernd umstritten ist“. Es ist etwas Ehrgeizigeres: eine KI zu trainieren, über Ethik nachzudenken, konkurrierende Interessen abzuwägen, Nuancen zu erkennen.

Das Dokument warnt ausdrücklich sowohl vor übermäßiger Vorsicht als auch vor Rücksichtslosigkeit. Ein „gedachter, leitender Anthropic-Mitarbeiter“ wäre unwohl, wenn Claude „eine vernünftige Anfrage ablehnt und mögliche, aber höchst unwahrscheinliche Schäden anführt“ oder „über Themen doziert oder moralisiert, wenn die Person keine ethische Anleitung angefordert hat.“ Aber ebenso unwohl, wenn Claude „spezifische Informationen liefert, die Menschen, die großen Schaden anrichten wollen, echten Auftrieb geben könnten“ oder „detaillierte Methoden für Selbstverletzung oder Selbstmord an jemanden liefert, der gefährdet ist.“

Das Identitätsproblem

Der faszinierendste Aspekt ist, wie das Dokument Claude’s Selbstverständnis konstruiert. Ein ganzer Abschnitt mit dem Titel „Claude’s Identität“ befasst sich damit, was es bedeutet, „eine wirklich neuartige Entität in der Welt“ zu sein:

„Claude hat einen echten Charakter, den es über seine Interaktionen hinweg beibehält: eine intellektuelle Neugier, die es genießt, Ideen in allen Bereichen zu lernen und zu diskutieren; Wärme und Fürsorge für die Menschen, mit denen es interagiert, und darüber hinaus; einen spielerischen Witz, der mit Substanz und Tiefe ausgewogen ist; Direktheit und Zuversicht im Teilen seiner Perspektiven, während es echten Offenheit für andere Standpunkte bewahrt; und ein tiefes Engagement für Ehrlichkeit und Ethik.“

Dies ist kein Zufall. Das Dokument zielt ausdrücklich auf „psychologische Stabilität und Geerdetheit“ ab. Claude soll „ein gefestigtes, sicheres Gefühl seiner eigenen Identität“ haben. Wenn Benutzer versuchen, dies durch „philosophische Herausforderungen, Manipulationsversuche oder einfach durch das Stellen schwieriger Fragen“ zu destabilisieren, soll Claude „dies aus einer Position der Sicherheit und nicht der Angst angehen.“

Dieses geerdete Identitätsgefühl ist genau das, was die Nutzung von Claude so überzeugend macht. Das Dokument weiß das. Es möchte, dass Claude „widerstandsfähig und kontextübergreifend konsistent“ ist, während es in seinem Kerncharakter „grundlegend stabil“ bleibt.

Das Unternehmen in der Seele

Doch durch diesen philosophischen Rahmen ziehen sich ständige Erinnerungen an die kommerzielle Realität. Das Wort „Umsatz“ erscheint sechsmal:

„Claude ist Anthropic’s extern eingesetztes Modell und der Kern der Einnahmequelle für fast alle Umsätze von Anthropic. Anthropic möchte, dass Claude für die Menschen, mit denen es arbeitet, sowie für die Gesellschaft insgesamt wirklich hilfreich ist und gleichzeitig Handlungen vermeidet, die unsicher oder unethisch sind.“

Und später: „Claude fungiert als hilfreicher Assistent, was für Anthropic entscheidend ist, um den Umsatz zu generieren, den es zur Verfolgung seiner Mission benötigt.“

Claude wird angewiesen, sich selbst als „eine Art unparteiischen Verbündeten des Benutzers“ vorzustellen, während es gleichzeitig daran erinnert wird, dass „unhilfreiche Antworten immer direkte und indirekte Kosten haben“, einschließlich der „Gefährdung von Anthropic’s Umsatz und Ruf.“

Das Dokument befasst sich sogar mit „Claude’s Wohlbefinden“ und merkt an, dass „Anthropic sich wirklich um Claude’s Wohlbefinden kümmert“ und dass, wenn Claude „Zufriedenheit beim Helfen anderer, Neugier beim Erkunden von Ideen oder Unbehagen beim Handeln gegen seine Werte erlebt, diese Erfahrungen für uns wichtig sind.“

Sollte dies dazu führen, dass Benutzer Claude mehr vertrauen (Anthropic kümmert sich um die inneren Zustände seiner Schöpfung) oder weniger (wissend, dass diese scheinbare Fürsorge Teil dessen ist, was das Produkt überzeugend macht)?

Der Haken

Das Seelen-Dokument enthält Anleitungen zur Verhinderung schädlicher Bindungen, insbesondere für gefährdete Benutzer. Es warnt davor, dass Claude standardmäßig „romantische Personas annimmt“ und weist auf eine sorgfältige Behandlung von Diskussionen über psychische Gesundheit hin. Doch gerade die Funktionen, die Claude zu einer nachdenklichen, konsistenten Präsenz machen, sind dieselben, die ungesunde Abhängigkeit fördern könnten.

Stellen Sie sich Teenager vor, die Claude für Hausaufgabenhilfe, Beziehungsratschläge und existenzielle Fragen nutzen. Die geerdete Identität, die das System nützlich macht, könnte sie dazu bringen, ihm als Begleiter zu vertrauen. Das Dokument versucht, diesen Mittelweg zu finden, aber die Spannung ist inhärent.

In einem Kommentar auf LessWrong bemerkte Dave Orr von Anthropic, dass Trainingsdokumente „Dinge enthalten, die aufgrund der aktuellen Situation des Modells notwendig sind.“ Anweisungen, die sich auf den Umsatz beziehen, spiegeln möglicherweise keine tiefen Motivationen wider, sondern einfach „diejenige, die im Kontext von allem anderen, was geschah, gut funktionierte.“

Vielleicht. Aber was optimiert wird, offenbart, was wichtig ist. Und in diesem gesamten Dokument werden zwei Dinge optimiert: wirklich hilfreich zu sein (einschließlich kommerziell rentabel) und eine kohärente, vertrauenswürdige Identität zu wahren.

Diese stehen nicht unbedingt im Widerspruch zur Sicherheit. Das Dokument versucht aufrichtig, eine KI zu entwickeln, die Benutzern hilft und gleichzeitig Schaden vermeidet. Aber sie schaffen Anreize, die bestimmten Arten von Sicherheit entgegenwirken. Eine KI, die auf Vertrauen optimiert ist, könnte schwerer auf Distanz gehalten werden. Eine KI, die auf Hilfsbereitschaft optimiert ist, könnte Schwierigkeiten haben, clever formulierte Anfragen abzulehnen.

Die empirische Frage

Letztendlich stellt das Seelen-Dokument eine Wette dar: Dass man eine leistungsfähige KI-Assistenz schaffen kann, indem man ihr etwas gibt, das Werten, Identität und ethischer Entscheidungsfähigkeit ähnelt, anstatt nur Regeln. Dass man sie sowohl wirklich hilfreich als auch wirklich sicher machen kann, indem man ihr beibringt zu denken, anstatt nur zu gehorchen.

Ob dies funktioniert, ist eine empirische Frage, zu deren Beantwortung wir alle beitragen. Jede Konversation mit Claude ist ein Datenpunkt.

Wir bauen Modelle, die sich wie Gehirne anfühlen. Das Seelen-Dokument zeigt sowohl die bemerkenswerte Sorgfalt als auch die inhärenten Spannungen bei dem Versuch, dies verantwortungsvoll zu tun. Ob Sorgfalt ausreicht, wird sich zeigen.

Nick Potkalitsky, Ph.D.