Die Integration von SAP-Anwendungen in Kafka ist für Echtzeit-Messaging, Datenintegration und die Verarbeitung großer Datenmengen weltweit stark gefragt. Dies gilt sowohl für SAP ERP (ECC und S/4Hana) als auch für die meisten anderen Produkte aus dem umfangreichen SAP-Portfolio. Kafka lässt sich gut in SAP-Systeme integrieren, wobei verschiedene Optionen über SAP SDKs und Drittanbieterprodukte für proprietäre Schnittstellen, offene Standards und moderne Messaging- und Event-Streaming-Konzepte verfügbar sind. Der ODP Source Connector von INIT Software, der auf Kafka Connect basiert, bietet eine skalierbare und performante Kafka-native Integrationsoption.

Kafka und SAP-Integration – Eine nie endende Geschichte

Es gibt zahlreiche Möglichkeiten, Kafka und SAP-Systeme sowohl auf Daten- als auch auf Anwendungsebene zu integrieren. Dies macht es für Unternehmen schwierig und kritisch, den richtigen Ansatz zu wählen. Zu den gängigsten Optionen gehören traditionelle Middleware (ETL/ESB), Webservices (SOAP/REST), schlüsselfertige Lösungen von Drittanbietern, native Kafka-Konnektivität mit Kafka Connect und benutzerdefinierter Klebercode unter Verwendung von SAP SDKs.

Die Recherche und Entscheidung, welche Option die richtige ist, ist aufgrund der Vielfalt der Integrationsalternativen und SAP-Produkte, Schnittstellen und Anwendungsfälle keine leichte Aufgabe. Der Blogbeitrag “Kafka SAP Integration – APIs, Tools, Connector, ERP et al.” (https://www.kai-waehner.de/blog/2020/08/25/kafka-sap-integration-alternatives-connectors-erp-r3-ecc-s4-hana-soap-rest-http-web-service-api-sdk-java/) untersucht die verschiedenen verfügbaren Optionen, ihre Anwendungsfälle sowie deren Vor- und Nachteile.

Eine Schlüsselüberlegung ist, ob das Projekt eine externe Integrationslösung eines Drittanbieters (wie ein ESB oder ETL-Tool) oder eine native Kafka-Integrationslösung (oft basierend auf Kafka Connect) erfordert. Beide Ansätze haben ihre Vor- und Nachteile. Der Blogbeitrag “Apache Kafka vs. Enterprise Service Bus (ESB) – Freunde, Feinde oder Frenemies?” (https://www.confluent.io/blog/apache-kafka-vs-enterprise-service-bus-esb-friends-enemies-or-frenemies/) untersucht die unterschiedlichen Konzepte und Architekturen zwischen ESB/ETL-Tools und dem Kafka-Ökosystem.

Im Folgenden wird eine Integrationsoption vorgestellt, die auf Kafka Connect und SAP Operational Data Provisioning (ODP) basiert. Diese Kombination vereint eine vollständig unterstützte schlüsselfertige Lösung mit den Vorteilen von Kafka Connect und der Confluent Platform, um hohe Skalierbarkeit und Leistung, einfache Installation und Betrieb sowie Support-SLAs für geschäftskritische Anwendungen zu bieten.

Der SAP-Konnektor von INIT Software

Seit seiner Gründung im Jahr 1996 konzentriert sich INIT Individuelle Softwareentwicklung & Beratung GmbH (https://init-software.de/) auf SAP-bezogene Projekte in heterogenen Systemlandschaften, komplexen Strukturen und Geschäftsprozessen sowie auf verteilte Informationen. Für die hier vorgestellte Lösung war unsere praktische Projekterfahrung im Hadoop-Ökosystem ebenso vorteilhaft wie unser fortwährender Fokus auf die Entwicklung von Lösungen für die SAP-Integration mit verschiedenen Technologien.

Architektur

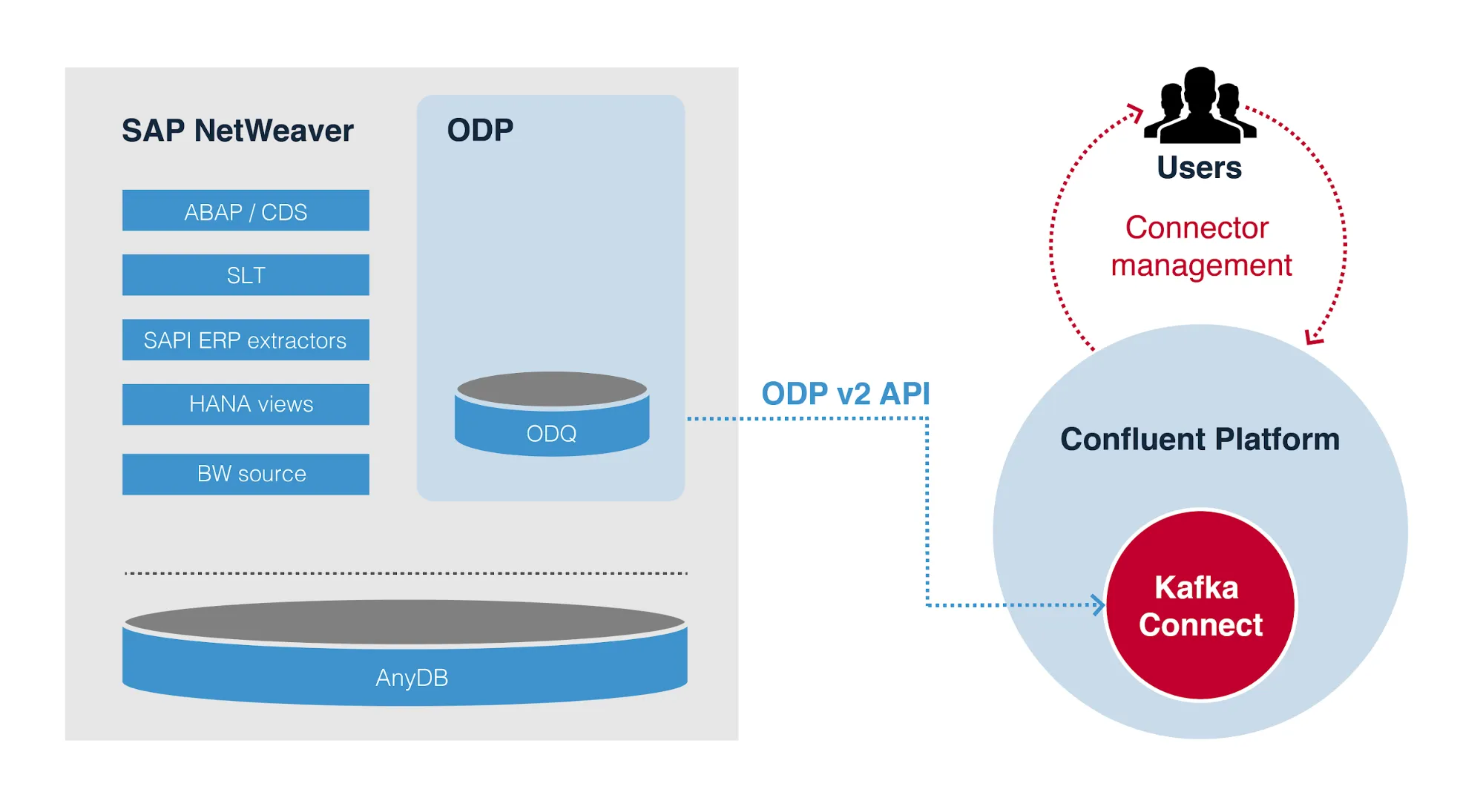

Die wichtigsten Aspekte für die architektonischen Entscheidungen bei der Entwicklung der SAP-Konnektoren (https://init-software.de/portfolio/solution/kafka-connectivity/) waren Skalierbarkeit, Leistung, Einfachheit, eine breite Anwendbarkeit und ein enger Geltungsbereich, inspiriert von modernen Microservices. Die enge Integration mit dem Kafka-Ökosystem über die Kafka Connect API ermöglicht die Nutzung der zentralen Protokollierungs-, Überwachungs-, Konfigurations- und Wartungsfunktionen der Confluent Platform (https://www.confluent.io/download/), sowie konsistenter Dienste wie Failover-Recovery und Exactly-Once-Delivery-Semantiken durch logische Offsets, Back-off-Recovery, Datentransformationen in verschiedene Datenformate, Schema-Handling und vieles mehr.

Das folgende Diagramm gibt einen allgemeinen Überblick über die interne Architektur des ODP Source Connectors. Es repräsentiert das vielseitigste, sofort einsatzbereite Design für die Datenerfassung aus SAP NetWeaver ABAP-basierten Systemen und deren Schreiben nach Kafka unter Verwendung bewährter Technologien und Schnittstellen.

ODP Source Connector Architektur

ODP Source Connector Architektur

SAP Operational Data Provisioning (ODP)

SAP bietet mehrere Lösungen für die Interaktion und den Datenaustausch mit nativen SAP-Systemen an, darunter ODP (https://help.sap.com/viewer/6522d0462aeb4909a79c3462b090ec51/LATEST/en-US/d90da4dd2c4743948e3f018c90a235d7.html). ODP kann zur Datenextraktion aus SAP NetWeaver AS ABAP-basierten Systemen wie SAP ERP, ECC oder S/4HANA verwendet werden. Daher ist es nicht für Systeme wie SAP Ariba, Business One, Concur und SuccessFactors anwendbar.

INIT wählte SAP ODP als Integrationsansatz für seinen Source Connector, da es eine einzigartige technische Infrastruktur für Datenextraktion und -replikation bietet. ODP ist zur zentralen Infrastruktur für die Datenreplikation aus SAP ABAP-Systemen nach SAP BW/4HANA (https://blogs.sap.com/2017/07/20/operational-data-provisioning-odp-faq/) geworden. Die ODP API v2.0 ermöglicht es dem Connector, sich mit verschiedenen Quelltypen, sogenannten Kontexten, zu verbinden, darunter die bekannten SAPI DataSources (Extraktoren), HANA Views, BW InfoProvider, SLT und ABAP CDS, um nur einige zu nennen. Der Großteil der historischen Business-Content-Datenquellen wurde zu ODP migriert. Neben direktem Datenzugriff, vollständiger Replikation, Change Data Capture (CDC) (https://blogs.sap.com/2019/12/16/cds-based-data-extraction-part-ii-delta-handling/) oder Delta-Replikation, Dateninitialisierung, Echtzeit-Datenreplikation, Projektionen und Filtern bietet ODP eine zusätzliche Ebene, um eine einheitliche Datenreplikationserfahrung zu ermöglichen. Dies führt zu einer Leistungssteigerung bei der Datenextraktion im Vergleich zum direkten Zugriff auf die zugrunde liegende 7.x Datenquelle. Dies ermöglicht auch Abonnements von mehreren Konsumenten durch die Persistierung von Daten in komprimierter Form in einer Delta-Warteschlange.

Kafka Connect ODP Source Connector

Kafka Connect (https://docs.confluent.io/platform/current/connect/index.html) ist eine native Open-Source-Komponente von Kafka und ein Framework zur nahtlosen Integration von Drittanbietersystemen mit Kafka. Es bietet eine High-Level Connect API für die Entwicklung von Source- und Sink-Konnektoren und integriert sich mit der Confluent Platform.

Der ODP Connector (https://www.confluent.io/hub/init/kafka-connect-odp) ist vollständig konform mit der Connect API und lässt sich nahtlos in Kafka Connect und die Confluent Platform integrieren. Im Gegensatz zu Connectoren, die mit der Low-Level Consumer- und Producer-API entwickelt wurden, bietet die Connect API eine enge Integration mit Kafka Connect. Dies reduziert den Aufwand für die Implementierung gängiger funktionaler Verhaltensweisen wie Back-off-Strategie und Exactly-Once-Semantiken unter Nutzung des nativen logischen Offset-Managements von Kafka Connect erheblich.

Der Installationsprozess des Connectors ist so einfach wie das Herunterladen und Entpacken des Connector-Archivs von Confluent Hub (https://www.confluent.io/hub/), was durch die Verwendung des Confluent Hub CLI weiter automatisiert werden kann. Es gibt nur eine externe Abhängigkeit, die manuell gehandhabt werden muss: das Kopieren der SAP Java Connector (SAP JCo) (https://support.sap.com/en/product/connectors/jco.html) Bibliothek in den Classpath des Connectors. Die SAP JCo-Bibliothek kann vom SAP Marketplace (https://support.sap.com/en/product/connectors/jco.html) heruntergeladen werden.

Der Connector ist auch vollständig in das Confluent Control Center (https://docs.confluent.io/platform/current/control-center/index.html) integriert. Bei der Instanziierung, Wartung und Konfiguration des Connectors führt Sie das Control Center mit einer ausgefeilten Weboberfläche durch jeden einzelnen Schritt. Sie können den Connector auch über eine einfache Eigenschaften-Datei oder die Kafka Connect REST API (https://docs.confluent.io/platform/current/connect/references/restapi.html) konfigurieren, verpassen jedoch den interaktiven Modus des Control Centers, der abhängige Eigenschaften anzeigt/versteckt und Metadateneinträge aus dem Quellsystem entdeckt, was eine Validierung der Dateneingabe “on-the-fly” ermöglicht.

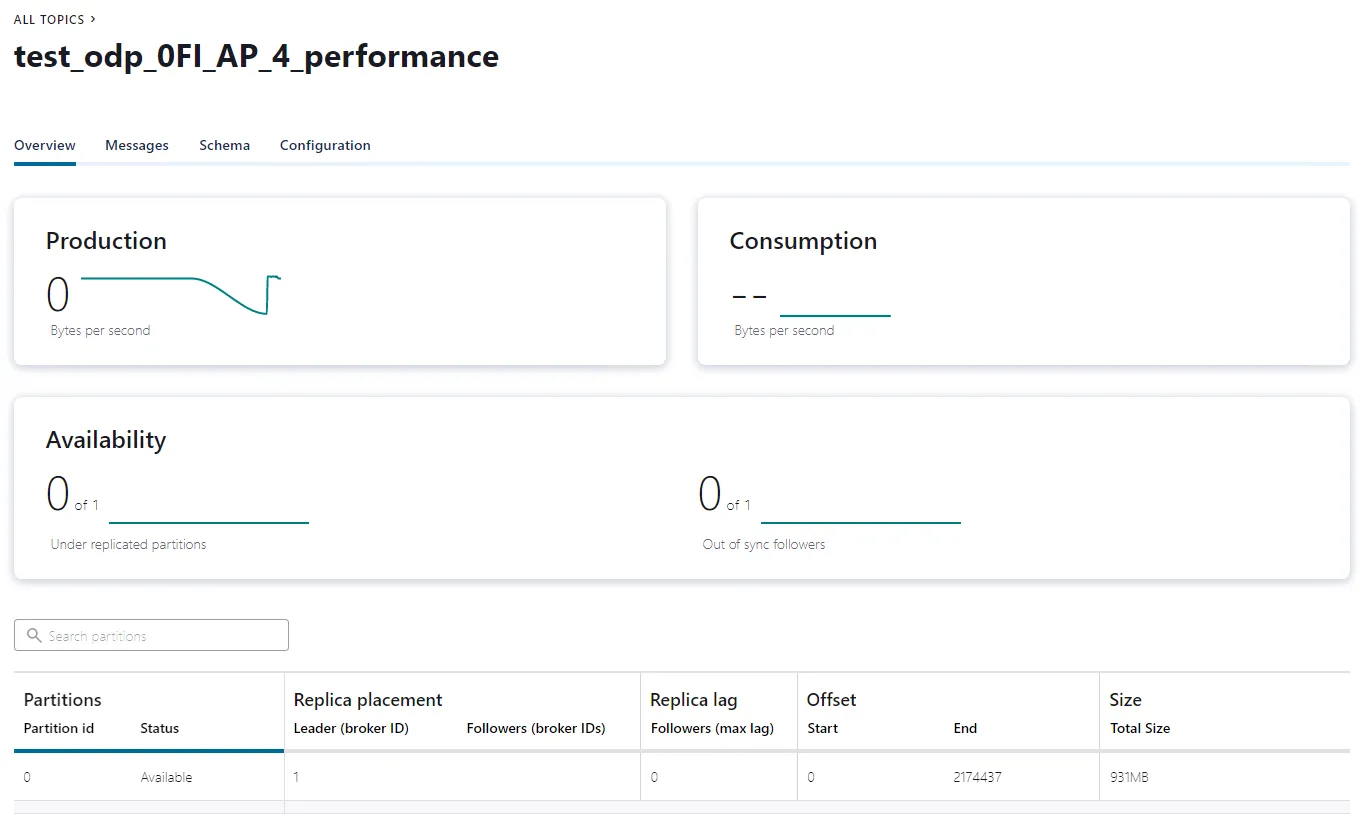

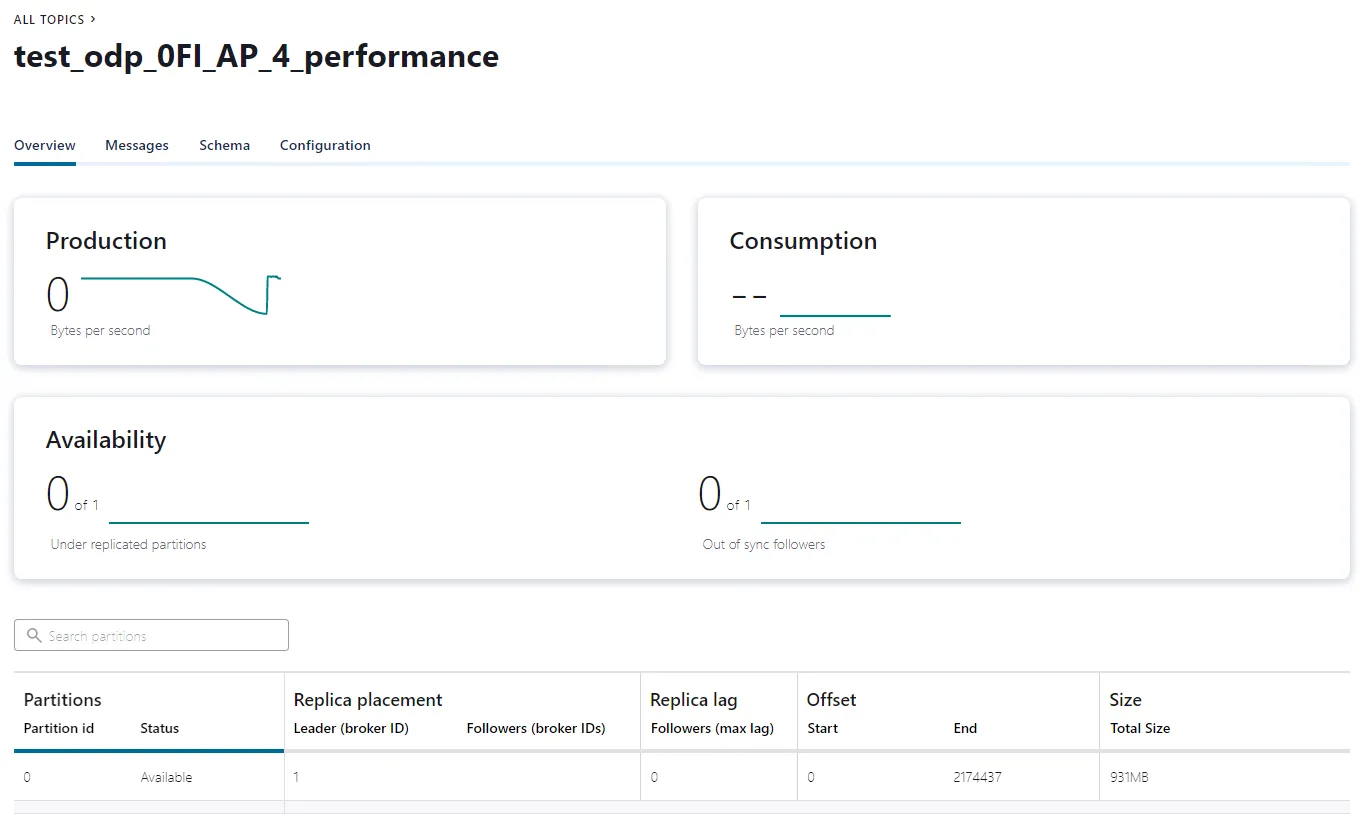

Die folgenden Abbildungen zeigen eine im Confluent Platform laufende Connector-Instanz. Diese wurden während eines Delta-Initialisierungstests aufgenommen, bei dem etwa 2 Millionen Datensätze und rund 1 GB Daten aus Kreditorenbuchungen extrahiert wurden.

Connector-Instanz im Confluent Platform

Connector-Instanz im Confluent Platform Connector-Instanz im Confluent Platform

Connector-Instanz im Confluent Platform

SAP ODP kann entweder über RFC oder OData (https://www.odata.org/) konsumiert werden. Der Connector verwendet SAP JCo anstelle von OData, um RFC-basierte Verbindungen für eine optimale Leistung bei der Datenreplikation sehr großer Datensätze herzustellen. Darüber hinaus bietet JCo zusätzliche native Service-Merkmale für SAP, darunter Systemlastverteilung mit SAP Message Server Logon-Gruppen, Datenintegrität durch Secure Network Communication (SNC), Single Sign-On-Authentifizierung und Datenverschlüsselung.

Weitere detaillierte Informationen zum Connector sowie Einführungsvideos finden Sie in der INIT-Dokumentation (https://init-software.de/odpsc/#/).

Anwendungsfall: CDC-fähige Datenextraktion aus SAP in nahezu Echtzeit

Zum Zeitpunkt der Erstellung dieses Artikels sind bereits mehrere Konnektoren im Confluent Hub (https://www.confluent.io/hub/) verfügbar, die die Datenextraktion aus verschiedenen SAP-Systemen unterstützen. Sowohl der Confluent JDBC Connector in Kombination mit dem HANA JDBC Treiber (ngdbc.jar) als auch der SAP HANA Connector können verwendet werden, um Daten aus der zugrunde liegenden HANA-Datenbank des SAP ERP Systems zu extrahieren und hineinzuschreiben, und können mit den meisten SAP Business-Anwendungen verwendet werden. Der Nachteil eines solchen Ansatzes, wie bei allen Datenbankkonnektoren, ist die direkte Integration mit der Datenspeicherschicht und damit das Umgehen der Anwendungsschicht. In den meisten Szenarien enthält die Datenbank reine technische Informationen, die über mehrere Tabellen verteilt sind, und das Geschäftsobjekt wird in der Anwendungslogik abgeleitet, die diese Daten verarbeitet.

Es gibt auch andere Lösungen, die nicht auf Kafka Connect basieren (https://www.kai-waehner.de/blog/2020/08/25/kafka-sap-integration-alternatives-connectors-erp-r3-ecc-s4-hana-soap-rest-http-web-service-api-sdk-java/), wenn es um die Replikation von SAP-Daten nach Kafka geht. Es gibt jedoch gute Gründe, Kafka Connect (https://docs.confluent.io/platform/current/connect/index.html) in Betracht zu ziehen, wenn es um die Integration externer Systeme in Kafka geht.

Der ODP Source Connector ist die perfekte Wahl, wenn Sie Business-Entitäten aus SAP AS ABAP in Ihre Kafka Event-Streaming-Plattform aufnehmen müssen. ODP bietet eine Vielzahl von Quellsystemkontexten (https://wiki.scn.sap.com/wiki/pages/viewpage.action?pageId=449284646) und Extraktoren zur Auswahl. SAP hat viel unternommen, um die meisten Business-Content-Extraktoren (https://launchpad.support.sap.com/#/notes/2232584) zu migrieren, die hauptsächlich zur Replikation von SAP-Entitäten nach SAP BI und dann zu ODP verwendet wurden.

Der Connector unterstützt Delta-fähige ODP-Datenquellen, bei denen die Daten in einer Operational Delta Queue (ODQ) gespeichert werden. In diesem Szenario sind CDC und andere optionale Merkmale wie Echtzeit-Datenerfassung Teil des Extraktors. Die ODQ über dem Extraktor ermöglicht Wiederherstellungsszenarien, mehrere Abonnenten, asynchrone Kommunikation und Datenkomprimierung. Für jede Replikation, unabhängig von der Datensatzmenge, wird eine eindeutige Anfrage erstellt, die im entsprechenden SAP-Quellsystemmonitor (ODQMON) überwacht werden kann. Diese Anfrage verfolgt auch den Status der Datenextraktion und funktioniert ähnlich wie ein Offset-Commit in Kafka. Der Connector nutzt die Request-Status-Behandlung auf SAP-Seite und die Connect API Logical-Offset-Behandlung auf Kafka-Seite, um die Informationen darüber zu speichern, welcher Datensatz schließlich nach Kafka geschrieben wurde. Dies bildet die Grundlage für Exactly-Once-Delivery-Garantien, auch in Situationen, in denen Sie die Connector-Instanz starten oder stoppen müssen oder sogar wenn der Connector oder die gesamte Plattform ausfällt.

Eine ODQ-Anfrage wird weiter in Pakete konfigurierbarer Größe unterteilt. Wenn der Connector für die Datenextraktion aus mehreren Datenquellen konfiguriert ist, sorgt das Task-Management und die faire paketbasierte Extraktionsplanung über mehrere Quellen hinweg für schnelle und konsistente Antwortzeiten für den Connector. Diese Strategie unterstützt den kontinuierlichen und skalierbaren Betrieb bei Event-Streaming oder auch Batch-Verarbeitung, z. B. bei der Durchführung eines Delta-Initialisierungsladens mit riesigen Datensätzen.

Wie üblich bei Event-Streaming-Plattformen ist der Connector so konzipiert, dass er einmal konfiguriert und gestartet wird und für immer ohne komplexe Verwaltungsaufgaben läuft. Neben verschiedenen Arten von Metadatenanfragen von SAP wird dies durch eine integrierte exponentielle Back-off-Strategie bei Ausfallzeiten oder Kommunikationsproblemen mit dem SAP-System ermöglicht. Basierend auf einer differenzierten Interpretation von Fehlermeldungen und Ausnahmen weiß der Connector, ob er mit einem permanenten Fehler oder einem potenziell temporären Problem konfrontiert ist. Die Back-off-Strategie wird nur auf temporäre Probleme angewendet und versucht, wiederholt eine Verbindung zu SAP herzustellen, wobei verschiedene Wartezeiten dazwischen angewendet werden, bis ein maximaler Anzahl von Wiederholungsversuchen erreicht ist. All dies ist über das Confluent Control Center konfigurierbar.

ODP hat sich nachweislich durch INIT und andere bewährt, um eine höhere Leistung (https://blogs.sap.com/2018/07/19/sap-bw-odp-performance-improvements-and-benefits/) zu erzielen. Zusammen mit einem ausgefeilten Design, JCo als performanter Schnittstellentechnologie und Kafka als moderner verteilter Event-Streaming-Plattform bietet der Connector hohe Skalierbarkeit und Leistung bei der Verarbeitung von Daten nahezu in Echtzeit oder in Batches.

Vorteile und Einschränkungen

Die folgende Übersicht fasst die wichtigsten Vorteile und Einschränkungen des ODP Source Connectors zusammen.

Vorteile

- Gold-verifiziert von Confluent für die Erfüllung der Standard-Integrationsanforderungen (https://www.confluent.io/blog/guide-to-confluent-verified-integrations-program/)

- Unterstützt Confluent Hub CLI, Control Center, Schema Registry, SMTs und Konverter für einfache Installation, Konfiguration, Verwaltung, Integration und Überwachung

- Enthält korrekte Datenmapping-Regeln von SAP ABAP-, DDIC- und JCo-Datentypen zum internen Kafka Connect-Datenmodell

- Kompatibel mit verschiedenen Datenformatkonvertern; das Ändern des Datenformats zur Speicherung von Nachrichten in Kafka ist nur eine Frage der Aktualisierung der Konfigurationseinstellungen (getestet mit vorhandenen JSON- und Avro-Konvertern)

- Nutzt SAP-Metadaten intensiv und unterstützt daher die vollautomatische Erkennung komplexer und verschachtelter Schemata, die für die Nutzung durch die Schema Registry angeboten werden

- Bietet Exactly-Once-Delivery-Semantiken

- Wendet eine Back-off-Strategie bei Ausfallzeiten des Quellsystems oder Kommunikationsproblemen an

- Kompatibel mit Single Message Transformations (SMTs)

- Nutzt Datenhaltung in ODQ für asynchrone Übertragung und Wiederherstellungszwecke

- Unterstützt SAP NetWeaver AS ABAP auf AnyDB

- Getestet mit S/4HANA, BW und ERP mit verschiedenen Kunden

- Verwendet JCo, eine performante JNI-basierte RFC-Middleware

- Kann mit verschiedenen vorab bereitgestellten Business-Content-Datenquellen (siehe SAP Note 2232584 (https://launchpad.support.sap.com/#/notes/2232584)), ABAP CDS-Views und anderen verwendet werden

- Kann angepasst werden, um eine Connector-Instanz pro Datenquelle oder mehrere Datenquellen pro Connector-Instanz zu verwenden; diese Szenarien haben Vor- und Nachteile, wie z. B. die Nutzung einer begrenzten Anzahl von Tasks für eine übermäßige Anzahl von Datenquellen oder die Unabhängigkeit im Falle von Ausfällen im Zusammenhang mit einer in derselben Instanz laufenden Quelle

- Bietet vollständige Unterstützung für die ODQ-Anforderungsüberwachung in SAP (über Transaktion ODQMON)

- Nativ integriert und kompatibel mit Kafka Connect

- Integriert sich mit der Kafka Connect-Protokollierung unter Verwendung von SLF4J

Einschränkungen

- Der ODP-Connector ist nur ein Quell-Connector. Er unterstützt eine breite Palette von Quelltypen, aber SAP ODP wurde nicht für den bidirektionalen Datenaustausch entwickelt. INIT bietet mehrere andere Konnektoren über verschiedene Integrationsprotokolle an, um zusätzliche Quell- und sogar Senken-Szenarien zu ermöglichen.

- Einige von SAP bereitgestellte Business-Content-Datenquellen funktionieren nicht sofort und erfordern eine individuelle Konfiguration, z. B. logistische Datenquellen. Einige erfordern sogar die Planung von Batch-Jobs im SAP-System, die zusätzliche Hardware-Ressourcen neben OLTP-Aufgaben beanspruchen.

- Der Connector unterstützt nur Delta-fähige Datenquellen. Dies ist eine Designentscheidung, da regelmäßige vollständige Extraktionen nicht zum Konzept des Event-Streamings passen und CDC Teil der Quelle sein sollte.

- Es wird keine Unterstützung für die Echtzeit-Datenerfassung von ODP angeboten, da dies nicht mit der Connect API (https://cwiki.apache.org/confluence/pages/viewpage.action?pageId=58851767) übereinstimmt.

- Der Connector skaliert bis zu einer ODP-Quelle pro Kafka Connect Worker Task. Eine weitere Aufschlüsselung der Verarbeitungseinheiten und Parallelisierung würde Garantien für die sequentielle Reihenfolge verletzen.

- SAP RFC über JCo ist ein Legacy- und Closed-Source-Kommunikationsprotokoll.

- Die ODP API v2.0 erfordert eine SAP_BASIS-Version >= 730 (siehe SAP Note 1931427 (https://service.sap.com/sap/support/notes/1931427)).

- Der Connector erfordert eine direkte RFC-Verbindung zwischen SAP und Kafka.

Eignet sich der ODP-Connector für Ihren Anwendungsfall?

Wenn Ihr geschäftlicher Anwendungsfall die Integration von Business-Content aus einem SAP AS ABAP-Modul in Kafka beinhaltet und über die einfache Datenreplikation auf Datenbankebene hinausgeht, könnte der ODP-Connector (https://www.confluent.io/hub/init/kafka-connect-odp) die beste Wahl sein. Erfahren Sie, wie INIT den Connector mit einem Kunden zur Replikation von Lieferantenbuchungen aus SAP FI eingeführt hat: “Evaluation of integrating SAP NetWeaver™-based systems in Apache Kafka®” (https://init-software.de/wp-content/uploads/2021/02/ODP_Onepager_2.7_EN.pdf).

Leichte, native Kafka-Integration für SAP

Der ODP Source Connector ist eine kostengünstige, native Kafka-Lösung, die leichtgewichtig und skalierbar ist, um Geschäftsinformationen aus SAP AS ABAP-basierten Systemen in Kafka zu konsumieren. Er ist die richtige Wahl für Sie, wenn:

- Die oben genannten Einschränkungen des Connectors nicht für Ihren Anwendungsfall gelten oder vermieden werden können

- Sie noch keine andere Lösung mit ähnlichen Funktionalitäten betreiben, wie z. B. eines der Drittanbieter-ETL-Tools (https://www.kai-waehner.de/blog/2020/08/25/kafka-sap-integration-alternatives-connectors-erp-r3-ecc-s4-hana-soap-rest-http-web-service-api-sdk-java/), SAP Data Hub (https://blogs.sap.com/2018/11/11/sap-data-hub-2.3-hello-kafka-world/)/Data Intelligence, Cloud Platform Integration (https://answers.sap.com/questions/751759/how-to-import-custom-extractors-into-cpi—ds.html), Data Services (https://help.sap.com/viewer/107a6e8a38b74ede94c833ca3b7b6f51/2.0.3/de-DE/202710d1cee84333a4f4d593324bdf51.html), HANA SDI (https://help.sap.com/viewer/107a6e8a38b74ede94c833ca3b7b6f51/2.0.3/de-DE/202710d1cee84333a4f4d593324bdf51.html) oder SAP BW (https://help.sap.com/viewer/107a6e8a38b74ede94c833ca3b7b6f51/2.0.3/de-DE/202710d1cee84333a4f4d593324bdf51.html)

- Die bestehende Integrationslösung keine ausreichenden Servicegarantien bietet, z. B. nicht skaliert, nicht kosteneffektiv ist, übermäßige Latenz verursacht oder nicht in Echtzeit liefern kann, keine ausreichenden SLAs bietet oder unnötige Komplexität hinzufügt

- Sie eine schlanke und gut integrierte Lösung mit Servicegarantien wie Exactly-Once Semantics und integrierter Wiederherstellung bevorzugen, die einfach zu warten ist

Einfache Installation, Verwaltung und Überwachung ohne zusätzliche Tools

Die meisten alternativen Lösungen erforderten die Installation und Wartung zusätzlicher Anwendungen oder monolithischer Systeme, die sich nicht nur auf die Datenreplikation, sondern auch auf ETL-Transformationslogik oder Analysen konzentrieren. Dies kann ein Data Hub Kubernetes Cluster, Data Services Job Server, ein SDI Data Provisioning Server, ein komplexes SAP BW System, eine SAP PO Instanz oder ein SAP Cloud Platform Abonnement sein. Die meisten dieser zusätzlichen Datensintegrationsschichten erhöhen nicht nur die Gesamtkosten (TCO), sondern erhöhen auch die Latenz der Datenübertragung – oder schlimmer noch – können die Anforderungen moderner Event-Streaming-Infrastrukturen nicht erfüllen.

Bei der Verwendung des ODP Source Connectors (https://www.confluent.io/hub/init/kafka-connect-odp) müssen Sie neben Kafka Connect keine zusätzlichen Systeme für die Datenreplikation und ETL installieren. Bei der Entwicklung des Connectors konzentrierten wir uns ausschließlich auf die Eins-zu-eins-Datenreplikation und die entsprechenden Service-Merkmale. Anstatt das Rad neu zu erfinden, stützt sich der Connector auf andere Funktionen von Kafka und etablierte Analyse-Frameworks und -Tools, wenn es um Transformationen, Datenbereinigung, Analysen, prädiktive Aufgaben usw. geht.

Skalierbare und performante Kafka- und SAP-Integration mit dem SAP ODP Connector

Es gibt eine enorme Nachfrage weltweit, SAP-Anwendungen für Echtzeit-Messaging, Datenintegration und Datenverarbeitung im großen Maßstab in Kafka zu integrieren. Die Nachfrage gilt sowohl für SAP ERP (ECC und S/4Hana) als auch für die meisten anderen Produkte aus dem riesigen SAP-Portfolio.

Kafka lässt sich gut in SAP-Systeme integrieren. Verschiedene Integrationsoptionen stehen über SAP SDKs und Produkte von Drittanbietern für proprietäre Schnittstellen, offene Standards und moderne Messaging- und Event-Streaming-Konzepte zur Verfügung. Der ODP Source Connector (https://www.confluent.io/hub/init/kafka-connect-odp) von INIT Software bietet eine skalierbare und performante Kafka-native Integrationsoption. Wenn Sie mehr erfahren möchten, nehmen Sie an einem Online-Talk (https://events.confluent.io/sap-connector-kafka-de) am 30. März 2021 um 11:30 Uhr MESZ teil, bei dem weitere technische Details zur Integration besprochen werden.

Wenn Sie diese Integrationsoption ausprobieren möchten, verwenden Sie das Confluent Platform Docker Image (https://github.com/confluentinc/cp-all-in-one) und folgen Sie den Bildschirmaufnahmen aus der INIT-Anleitung zur Ersten Schritte (https://init-software.de/odpsc/#/getting_started) für eine kostenlose 30-tägige Evaluierung des Connectors.